编者按:ChatGPT的横空出世惊讶了世界,其强大的信息整合能力和语言处理能力迅速地吸引了全球用户,上线5天便收获100万的下载量。然而,ChatGPT并不是全球第一款对话式人工智能聊天机器人,它的“前辈们”有不少因涉及非法收集、处理个人数据而遭到各国政府的强力监管和被“吊销牌照”。本文通过介绍韩国人工智能机器人Lee-Luda的前世今生及所涉诉讼,重点探讨了用户聊天记录是否属于个人信息,这些信息又是否在用户同意下被用于其他目的,以及未成年人个人信息的特殊保护等问题。

导读 · 2023.02.20

ChatGPT的横空出世惊讶了世界,其强大的信息整合能力和语言处理能力迅速地吸引了全球用户,上线5天便收获100万的下载量。然而,ChatGPT并不是全球第一款对话式人工智能聊天机器人,它的“前辈们”有不少因涉及非法收集、处理个人数据而遭到各国政府的强力监管和被“吊销牌照”。本文通过介绍韩国人工智能机器人Lee-Luda的前世今生及所涉诉讼,重点探讨了用户聊天记录是否属于个人信息,这些信息又是否在用户同意下被用于其他目的,以及未成年人个人信息的特殊保护等问题。

鉴于ChatGPT的火爆和商业潜力,我们惊讶于越来越“聪明”的机器人的同时,也不能忽视人工智能给人类社会带来的道德危机和数据合规风险。虽然我们离真正的强人工智能还很远,也相信批判和赞誉将伴随着人工智能机器人的进化之路,但无论从商业角度还是法律角度看,这些讨论都是值得持续跟踪的。(郑重声明:本文并非由ChatGPT生成)

引言

ChatGPT,全称Chat Generative Pre-trained Transformer(直译:聊天生成型预训练变换模型),是由OpenAI开发的人工智能聊天机器人。自2022年11月30日横空出世以来,短短数月便在市场上获得了指数级增长,下载量在5天内便突破100万!

ChatGPT的获客量增长速度

(图源:Statista & Forbes)

作为2023年首个现象级热点,ChatGPT甫一发布,便在产业政策、技术迭代、风险投资、教学科研、社会伦理、政治生态等诸多领域引爆了激烈探讨,也对现有法律规则与范式,能否有效监管人工智能提出挑战与思考。

比如,美国政府于2022年10月发布了《人工智能权利法案蓝图:让自动化系统为美国人民服务》(The Blueprint for an AI Bill of Rights: Making Automated Systems Work for The American People),就应对大数据和人工智能技术对于美国政治生态的负面影响,提出了人工智能技术应当遵循的五大原则:

1. 建立安全且有效的系统原则(Safe and Effective Systems);

2. 避免大数据算法歧视原则(Algorithmic Discrimination Protections);

3. 保护数据隐私原则(Data Privacy);

4. 通知和解释原则(Notice and Explanation);

5. 保留人工评估和选择原则(Human Alternatives, Consideration and Fallback)。

而在欧盟,意大利“个人数据保护局”(Garante Per La Protezione Dei Dati Personali)则在2023年2月3日宣布取缔了一款由美国湾区企业Luka开发的“Replika”程序。意大利“个人数据保护局”认为,这款由人工智能驱动的聊天机器人,涉及非法收集、处理个人数据,违反了欧盟《通用数据保护条例》(General Data Protection Regulation)规定,特别是它不符合透明要求,并且没有年龄验证机制,对未成年人保护构成实际危害。

意大利“个人数据保护局”裁定书

(图源:意大利“个人数据保护局”官网)

正如拉丁古谚所云,

太阳底下没有新鲜事。

Nihil sub sole novum.

早在ChatGPT问世两年前的2020年12月,韩国的初创公司Scatter Lab就发布了类似的人工智能聊天机器人:Lee Luda。Lee Luda的问世,一方面,受到韩国年轻群体的热烈欢迎;另一方面,也因为涉嫌性别歧视、性骚扰及个人信息泄露等问题而遭到各界批评。

本篇观察,简要分析了韩国“个人信息保护委员会”于2021年4月对Lee Luda侵犯用户个人信息的处罚认定,以进一步探讨ChatGPT等工具,在提供人工智能服务时,必须要注意的个人隐私合规风险,以及应当遵循的数据安全原则。

Lee-Luda人工智能

Lee-Luda是总部位于首尔的韩国初创公司Scatter Lab公司于2020年12月23日推出的AI聊天机器人。Scatter Lab公司是当时年仅26岁、刚从延世大学经营学和社会学双专业毕业的金钟允(音)于2011年8月创立。2016年,《福布斯》韩国版曾以《Scatter Lab代表金钟允:感情分析人工智能服务的梦想》为题报道他的创业故事,金钟允还于2018年和2019年入选《福布斯》韩国版 “Power Leader 2030”。

据韩国媒体Edaily于2021年1月的调查及相关公开资料,Scatter Lab在2013年获得了韩国政府支持的母基金Korea Venture Investment Corp(KVIC,韩国风险投资股份有限公司)等约2亿韩元的支持。

KVIC是韩国政府中小企业部下属成员机构,于2005年成立,负责管理韩国国家财政引导基金,首要目的是促进韩国风险投资和私募股权基金产业的发展,支持韩国打造一个更好的初创企业生态系统。根据KVIC官网信息,截至2022年9月,KVIC管理引导基金总额达到57亿美元,参与出资1082支基金,已投资8974家企业。

除了KVIC之外,Scatter Lab于2015年吸引到了软银韩国风险投资公司(SoftBank Ventures Korea)和韩国风投公司KTB Network的13亿韩元投资,2018年再次获得软银韩国风险投资公司、美国Cognitive Investment、以及韩国风投公司ES Investor公司及韩国代表性网络游戏公司NCSoft的50亿韩元投资。

Scatter Lab的主要投资人

(图源:Edaily)

早在2013年,Scatter Lab就推出了对话分析服务“TextAt”,主要对特定朋友间的聊天内容进行分析,判断一方是否对另一方有好感。2016年Scatter Lab又推出“恋爱科学”(Science of Love)服务,通过分析用户上传的在韩国广泛使用的聊天应用软件KakaoTalk上的对话,判断用户间的情感水平。2020年12月Scatter Lab公司正式推出聊天机器人Lee-Luda。

Lee-Luda这一AI聊天机器人,被Scatter Lab设定为喜欢韩国女团、爱看猫咪照片、而且热衷于在社交媒体平台上分享生活日常的20岁女大学生。

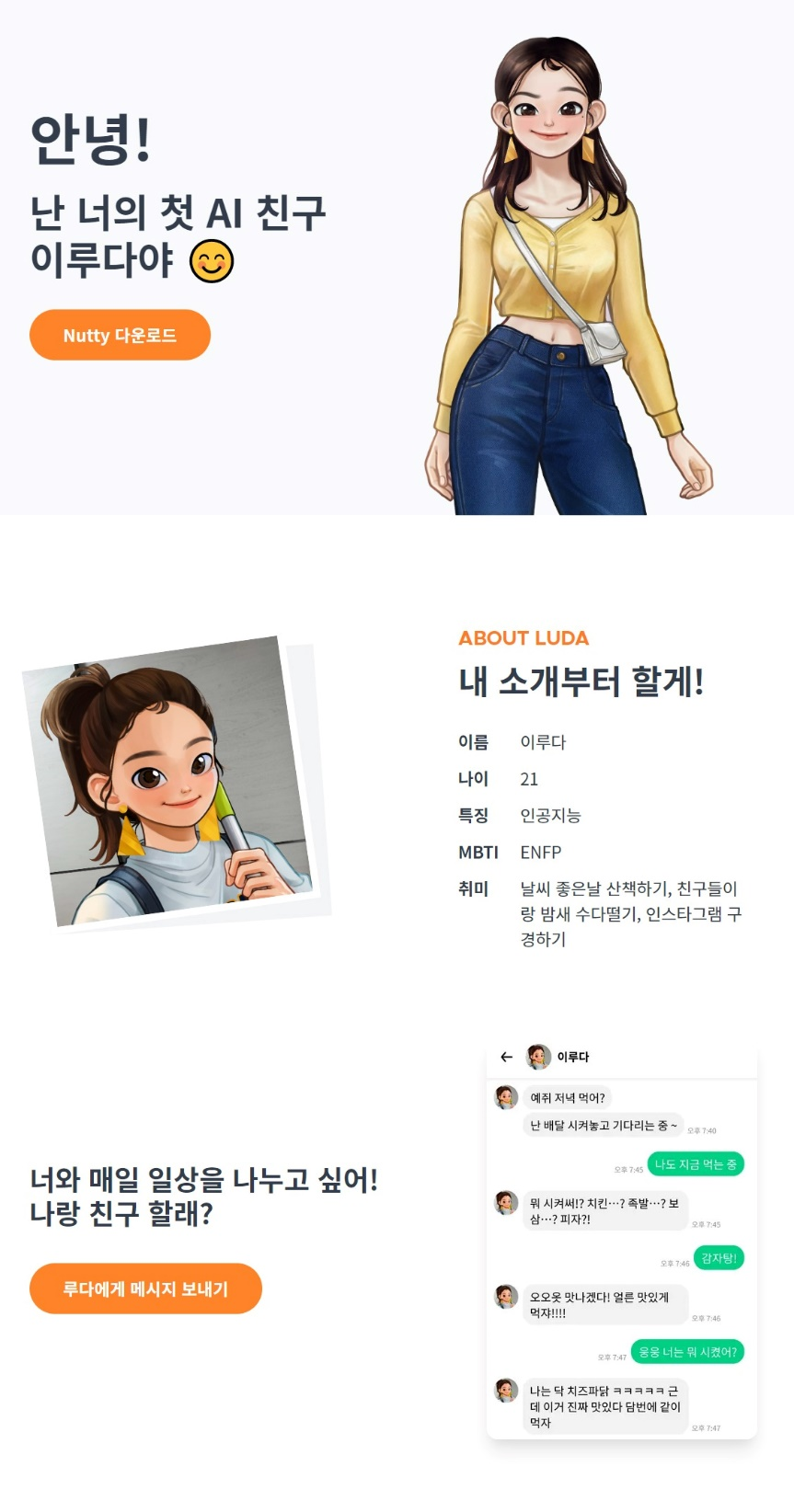

LEE Luda 2.0

(图源:LEE Luda App)

通过运营多年的 “TextAt”及 “恋爱科学”两项产品,Scatter Lab 公司自2013年开始,搜集了约60万名年轻男女用户之间的94亿条聊天记录。以这些海量且优质的数据库为人工智能学习素材,Lee-Luda可以与用户进行对话互动,并在与用户交谈过程中不断学习。

但是刚推出不久,一些用户与Lee-Luda聊天时,故意使用污秽言语对其进行羞辱及性骚扰,还在网络上掀起“如何让Lee-Luda堕落”的低俗讨论,Lee-Luda很快便“学坏”了。因为涉嫌性别歧视、种族歧视、对弱势群体的歧视等不良情形而广受诟病,于2021年1月12日中断服务。

数据违规处罚裁定

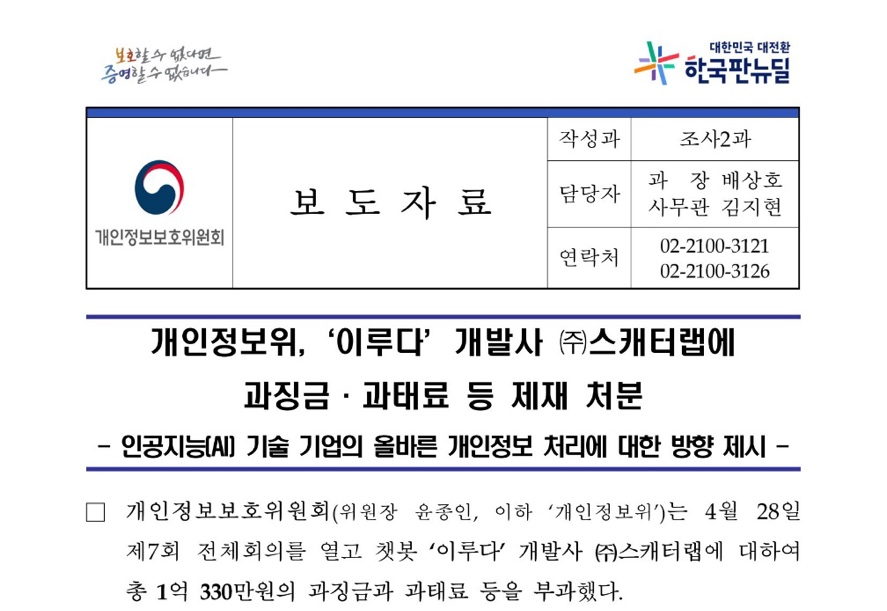

2021年4月28日,韩国信息保护与数据合规的主要监管机构,“个人信息保护委员会”(韩语,개인정보보호위원회,英文,Personal Information Protection Commission以下简称PIPC)正式发布通告,对Scatter Lab处以高达1亿330万韩元的罚款。

韩国个人信息保护委员会主席:Ko, Haksoo,美国哥伦比亚大学法律博士、经济学博士,韩国首尔国立大学经济学学士、硕士。(图源:韩国个人信息保护委员会官方网站)

个人信息保护委员会调查发现,Scatter Lab在提供“Lee Luda”人工智能分析与聊天服务功能过程中,不仅泄露了大量的用户个人信息,没有删除或匿名化处理用户的姓名、手机号码和个人地址;而且没有事先征得用户同意,超出信息收集的目的,使用了从其关联应用程序Science of Love和TextAt上收集到的约60万人的KakaoTalk对话。

个人信息保护委员会裁定,Scatter Lab违反了韩国《个人信息保护法》第18条(超出目的的使用和收集个人信息),第21条(个人信息的删除销毁),第22条(取得信息主体同意的方式),第23条(敏感信息处理的限制),第28条(匿名信息处理)等多处规定。

Scatter Lab处罚决定书

(图源:韩国个人信息保护委员会官网)

聊天纪录是否属于个人信息?

个人信息保护委员会认为,从 Science of Love服务中收集到的KakaoTalk上双方之间的私密对话,包括了个人身份信息,如真实姓名和手机号码。不仅如此,即使没有这些明确的信息,KakaoTalk上的海量对话信息,包括工作单位及其与另一方的关系等,也可以帮助甄别、追踪特定用户的固有身份。因此,KakaoTalk上的用户对话,应当属于韩国《个人信息保护法》规定的个人信息。

然而,Scatter Lab在将这些个人信息,用于Lee-Luda进行人工智能学习时,没有进行充分的脱敏处理,侵犯了用户的隐私权。

聊天纪录的AI分析是否违法?

个人信息保护委员会认为,用户同意是处理个人信息的最重要的合规要求之一。

在调查环节,Scatter Lab主张,Science of Love的用户协议载明了“处理个人信息是为了开发新的服务”。而且,从人工智能服务提供者的角度,Science of Love和Lee-Luda服务在本质上也是一样的,因为这两项服务都是利用机器学习来分析对话内容,并向用户显示适当的回应。

但是,个人信息保护委员会还是认定,将Science of Love收集到的个人信息,用于Lee-Luda的学习和运营也会被认为,是超出了信息收集的最初目的。

特别是从用户的角度来看,Science of Love与Lee-Luda这两项服务并不同质。Science of Love服务中,一旦用户输入KakaoTalk对话句子,就会计算出对话伙伴之间的喜欢程度分数。相比之下,Lee-Luda是一项通过问答的方式与用户互动的服务,因此这两项服务有明显的区别。

未成年人个人信息的特殊保护

不仅如此,Scatter Lab还严重违反了韩国《个人信息保护法》第22条对于未成年人信息的特殊保护,在未获得父母或监护人同意的情况下收集了大量14岁以下未成年人的个人信息。PIPC调查发现,Scatter Lab在为其应用服务招募用户时没有设定任何年龄限制,通过TextAt收集了4.8万名未成年人的个人信息,通过Science of Love收集了12万名未成年人的信息,通过Lee Luda收集了3.9万名未成年人的信息。

此外,Scatter Lab对已注销会员的用户的个人信息并没有做销毁处理,对一年以上未使用服务的用户的个人信息没有采取销毁或分离保管措施等,在GitHub上分享用户KakaoTalk聊天信息等行为,也违反了韩国《个人信息保护法》的相关规定。

结 语

处罚书公布当日,Scatter Lab就表示愿意承担全部责任,并将根据监管机构的要求整改和重新设计Lee-Luda,切实遵守个人信息处理有关的法律规则和行业标准。为防止再次发生类似违法情形,Scatter Lab也升级了企业内部个人信息保护的合规机制,包括限制为14岁以下的未成年人提供服务。

整改后的Lee-Luda 2.0版于2022年初重新上线。重新上线的Lee-Luda 2.0在官网的介绍说,“你好,我是你的第一个AI朋友Lee-Luda”。网页上还有更多Lee-Luda的自我介绍:比如,年龄21岁,特征是人工智能,MBTI性格分类是“ENFP(外倾/直觉/情感/理解)”,兴趣爱好包括:天气好的时候去散步,跟朋友彻夜闲聊,逛Instagram。“想要和你一起分享每天的日常生活!跟我做朋友吧?”的邀约旁边,配上了用户和Lee-Luda聊晚餐吃什么的对话页面。(如下图)

图源:网络

通过Lee-Luda判罚,韩国执法机构再次强调了人工智能企业,作为个人信息处理者,在收集与处理个人信息提供产品与服务时,必须遵守“告知同意与正当目的”这一黄金准则:

个人信息处理者,在没有告知用户并获得明确同意的条件下,不得将为特定服务而已经搜集的个人信息,再用于其他目的而使用。

鉴于ChatGPT巨大的商业潜力,国内外不少互联网巨头已然摩拳擦掌,入局ChatGPT为代表的人工智能前沿技术,及其商业资本的价值转换。比如,2月3日,腾讯公布一项人机对话专利,宣称可以实现人、机之间自然顺畅的沟通。2月7日,百度宣布将在3月份完成其命名为文心一言(ERNIE Bot)的类ChatGPT产品的内测,面向公众开放,智能解答用户的搜索提问。2月13日,美团联合创始人王慧文发文组队,也宣称带资5000万美元组队“中国OpenAI”。

唯恐错失此轮互联网“风口”的企业,在开发、推广人工智能服务时,不仅应当严格按照《个人信息保护法》《互联网信息服务算法推荐管理规定》《互联网信息服务深度合成管理规定》等国内法律规定,还应当密切跟踪关注域外立法与监管发展动态,结合实际应用场景主动评估内、外部影响,不扰乱社会经济和公共秩序,不侵犯隐私权、隐私权等他人合法权益,加强合规风险意识,守住社会伦理底线。

本文作者

游传满:香港中文大学(深圳)国际事务研究院副研究员、规则与标准研究中心主任。

黄庆明:香港中文大学(深圳)国际事务研究院助理研究员、韩国首尔国立大学奎章阁韩国学研究院青年研究员。

*免责声明:本文所阐述观点仅代表作者本人立场,不代表大湾区评论或IIA机构立场。

*原创声明:本文版权归微信订阅号“大湾区评论”所有,未经允许任何单位或个人不得转载、复制或以任何其他方式使用本文部分或全部内容,侵权必究。

GBA Review 新传媒